基于Ollama和OpenClaw实现100%本地化部署AI助手的完整指南,涵盖环境准备、模型部署、多模型切换及Telegram对接,确保免费、断网可用、灵活扩展的特性。内容综合多篇实践文档,关键步骤均附引用来源。

完全本地化

数据无需上传云端,隐私零泄露,断网环境下仍可运行。

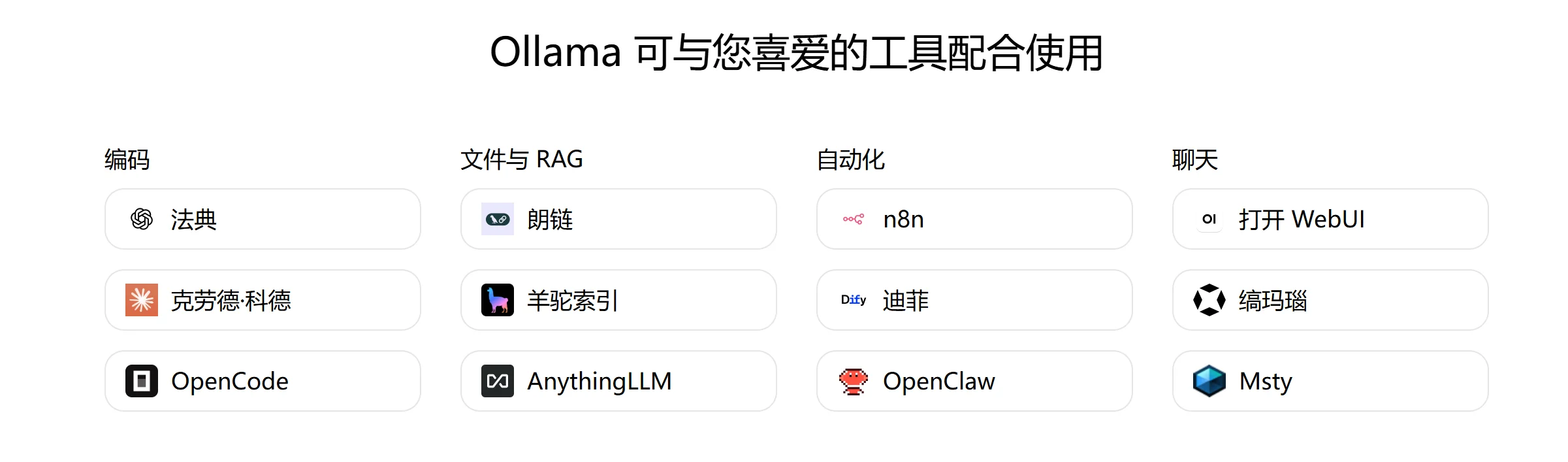

通过Ollama管理本地模型(如Qwen3、GPT-OSS等),OpenClaw负责任务调度,形成闭环链路。

多模型自由切换

支持主流开源模型(Qwen3、GLM-4.7、GPT-OSS等),通过修改配置文件即可切换。

硬件友好

最低配置:16GB内存(MacOS)或GPU服务器(如NVIDIA显卡);推荐32GB以上内存+GPU加速。

Git(Windows管理员权限执行):

Ollama客户端:

官网下载安装包(https://ollama.com/download)或命令行安装(Linux):

推荐模型(需64k以上上下文窗口):

| 模型名称 | 特点 | 下载命令 |

|---|---|---|

qwen3-coder | 编码任务优化 | ollama pull qwen3-coder |

gpt-oss:20b | 平衡性能与速度 | ollama pull gpt-oss:20b |

glm-4.7 | 通用能力强 | ollama pull glm-4.7 |

通用命令:

curl -fsSL https://openclaw.ai/install.sh | bash

Windows专用:

iwr -useb https://openclaw.ai/install.ps1 | iex

启动服务:

ollama launch openclaw

配置文件修改(关键步骤):

编辑\~/.openclaw/openclaw.json,指定Ollama的本地API地址(如http://127.0.0.1:11434/v1)和模型ID:

{

"models": {

"providers": {

"ollama": {

"baseUrl": "http://127.0.0.1:11434/v1",

"apiKey": "任意字符串(如ollama-local)",

"models": [{"id": "qwen3", "name": "Qwen3"}]

}

}

},

"agents": {

"defaults": {

"model": {"primary": "ollama/qwen3"}

}

}}注意:api字段需设为openai-completions,否则可能无法响应。

切换模型:

修改配置文件中的id和name字段,例如从qwen3改为gpt-oss:20b,重启服务生效。

验证部署:

访问http://localhost:18789?token=配置中的token,输入问题测试回复是否来自本地模型。

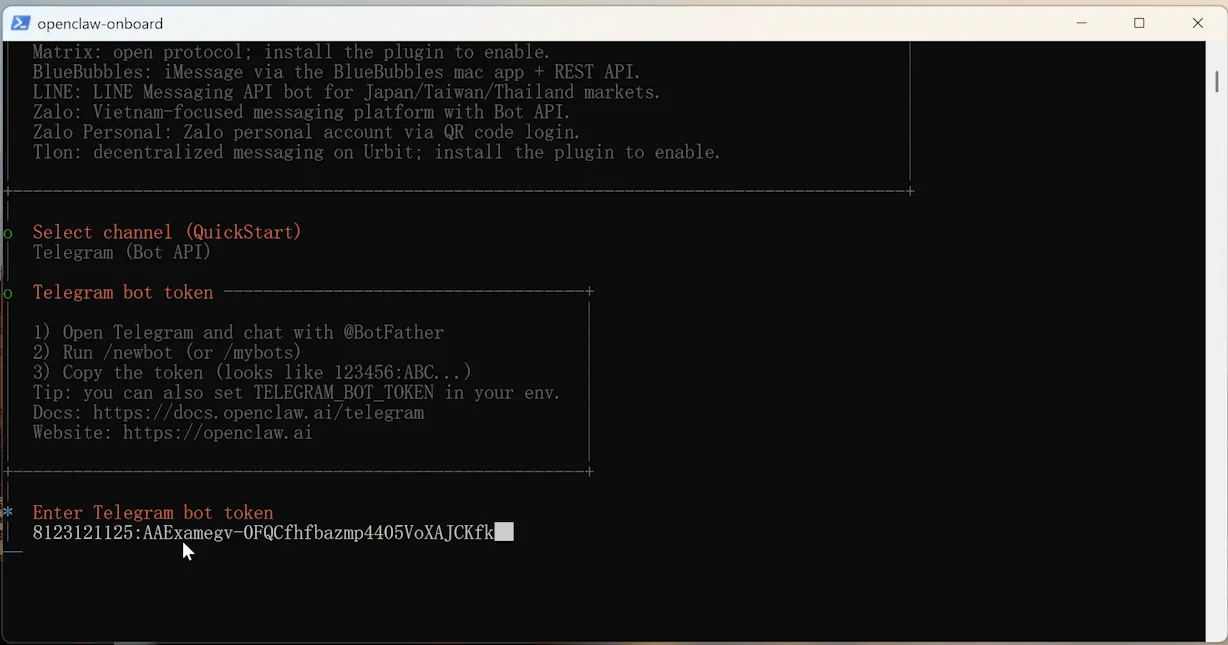

创建Bot:

通过@BotFather申请新机器人,获取Token(如8123121125:AAExamegv-0FQCfhfbazmp4405V0XAJCKfk)[用户提供]。

配对OpenClaw:

在Powershell中执行(替换配对码):

openclaw pairing approve telegram DLW7HQ69

重启服务:

ollama launch openclaw

GPU加速:若使用NVIDIA显卡,需安装nvidia-container-toolkit并配置Docker。

性能调优:调整contextWindow和maxTokens参数以匹配硬件能力。

安全部署:建议Docker容器以非root用户运行,挂载只读文件系统。